|

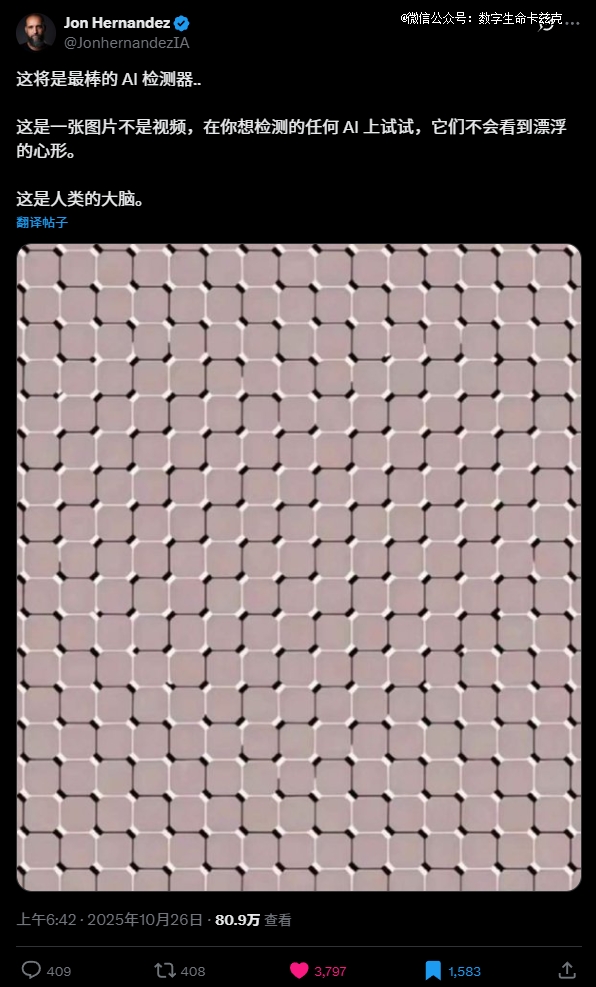

这两天在网上刷到了一张图,很有意思。  其实就是一张经典的视觉错觉图,做了个漂浮的心形图案。 如果你用电脑打开这篇文章的话,没看到这个图动起来的话,那就就用手机打开或者直接把页面缩小。 瞬间,你就能看到这个图里的爱心,直接左右横跳起来了。。。 看到的兄弟可以把公屏打在弹幕上。 这哥们说,这是最 好的AI探测器,说,没有AI能看到这个图中间还有个爱心。 我顺手找了几个模型试试,结果无一例外,果然,没一个AI认出来。 比如Gemini 2.5 Pro,率先翻车。 给我扯了一堆有的没的,然后说了一句,圆圈。 圈你妹= = GPT-5-Thinking,想了2分多分钟,直接阵亡。 甚至,我还试了一下豪华版GPT-5 Pro。 在长达7分钟的花里胡哨之后,宣布直接躺平。 国产三巨头,豆包、Qwen、元宝,也都倒在了这张图的淫威之下。 DeepSeek因为没有多模态,所以反而逃过一劫。 在这测试过程中,我一度产生了一种错觉,就是,不会这些模型,不知道啥叫心形吧。 导致我非常智障的还去问了一下。。。 认识,看来没啥问题。。。 你们也能看到,我用的都是同一套提示词。 我觉得,同样的问题交给随便的一个人,应该都是能得出正确答案的。 所以,我就产生了很强的好奇。 这到底是什么? 再抽空花了一晚上的时间,去DeepReaserch和研究之后,我看到了一篇AI这块超级好玩的论文。 是今年5月发的,叫《Time Blindness: Why Video-Language Models Can’t See What Humans Can?》 真的,AI研究到后面,怎么发现,研究的全是人类。。。 这个标题翻译过来大概就是: 为什么视觉语言模型看不到人类能看到的东西? 虽然文中的例子是视频,跟我们上文的爱心图有点不太一样,但是底层原理,其实在我读完以后看来,是完全一脉相通的。 这项研究设置了一个基准,叫做SpookyBench,合成了一堆由噪点组成的视频,是黑白的。 随便暂停一下,这个视频的每一帧,看起来都像是随机的雪花点或者电视噪音。 但是播放的时候,我们可以非常明确的看到一只鹿。 这个鹿我甚至都没法截图给大家看,只要截图出来就必是噪点图。 这玩意,跟最近X上流行的一个视觉错觉的宝剑视频还挺像的。 你只要一暂停,就啥也看不到了。 还有很多类似的。 这篇论文就拿451个这样的视频,组成了一个基准,去视觉大模型进行测试。 结果就是,非常的喜闻乐见。 人类可以毫不费力地识别出这些视频中的形状、文本和图案,准确率超过98%。 而大模型的准确率,为0%。 全军覆没,无一幸免。 我已经很久很久没见过这么多的0分了。 太特么赤鸡了。 无论模型架构大小、训练数据规模、是否经过微调或采用何种提示策略,AI从未答对任何一段视频的内容。 我也拿几个模型去试了一下,同样的那头鹿的视频,Gemini2.5-Pro同样无法识别。 原因其实特别简单。 AI是空间维度上的王 者,但却是时间维度上的瞎子。 我这么说可能会有点难以理解。 我们可以先想想,现在所有的大模型,包括GPT-5、Gemini 2.5 Pro,它们是怎么看视频的。 很多人以为他们跟人一样,就是搬个小板凳搁那坐着,目不转睛的看完了整个视频? 错了,不是这样的。 现在大模型的主流做法,本质上不是看视频,是看照片。 “哦,这张照片里有噪点。” “哦,这张照片里还是噪点。” “哦,这张照片里依然是噪点。” 最后,它得出结论: “这特么就是个噪点视频。” 这就是最本质的问题所有,AI彻底丢掉了所有的帧与帧之间的信息。 而那个“漂浮的心形”和“噪点中的鹿”,其实本质上,它们的信息恰恰只存在于帧与帧之间。 这其实,就是,时间维度。 在任何一个单独的瞬间,心形和鹿都是不存在的,都是不可见的。 你只有把这些瞬间连续播放,让时间流动起来,你才能看到他们。 突然想起了以前做交互设计的时候,有一个几乎刻在我血液里的心理学,这玩意,叫格式塔心理学。 几乎就是用户体验行业的基石之一。 里面有一个非常牛逼的原则,叫“共同命运法则”。 这个法则是说,我们的大脑会本能地、自动地、不讲道理地,把朝着同一方向运动的物体,识别为一个整体。 这玩意几乎就是刻在我们的史前基因里面的。 比如在几万年前的草原上,我们的老祖宗“智人坤坤”,正蹲在草丛里。 他眼前是一片随风摆动的、杂乱的灌木。 突然,在灌木丛中,有一小片叶子的摆动方式,跟周围所有的叶子都不一样,它们在以一个相同的规律,朝着同一个方向缓慢移动。 坤坤的大脑,甚至不需要他思考,就会立刻拉响警报: “卧槽!快跑!老虎来了!!!有危险!!” 那些“共同运动”的像素点,在坤坤的大脑里自动组合成了老虎这个整体。 所以,你看,当你看到那个“噪点鹿”的视频时,你根本不需要努力,你大脑里的共同命运法则就自动启动了。 它帮你把所有一起往上移动的噪点归为一类,识别为“鹿”,把所有一起往下移动的噪点归为另一类,识别为“背景”。 你之所以能看到鹿,不是因为你看见了鹿,而是因为你看见了运动本身。 但AI不行。它没有我们这套“共同命运法则”的视觉系统。 它的架构,论文里叫 "Spatial Bias"空间偏见,决定了它只能先去识别空间上的特征。 它看每一帧,都是一堆杂乱无章的噪点。 但它无法从时间的维度上,去发现这些噪点之间“共同的命运”,所以,它看不到那只鹿。 这个问题,在论文中,被称为。 时间盲视,Time Blindness。 目前看,好像没有啥解决办法,不仅仅是一个技术漏洞了,或者一个可以喂数据就能解决的小bug,论文里也试了,微调训练也没用。 我们活在流中,而AI活在帧中。 这个世界对我们来说,首先是连续的、流动的、充满过程的。 而对AI来说,这个世界首先是离散的、静态的、充满物体的。 太有意思了,这是我最近,看到的最哲学最让我喜欢的一段表述。 我们现在理解了噪点,让我们回到最开始的爱心。 这时候,我其实又产生了问题,不对啊,运动这事,是时间维度的,但是那个爱心,明明就是一张图,根本没有时间属性,那这玩意,到底为啥也能让人感觉到,动呢??? 我没理解,于是,我又进行了新一轮的研究。。。 结果,答案居然让我有点无语。。。 答案特别简单,就是因为: 因为我们自己会动。 还是,不受控制地动。。。 在20世纪50年代,眼动领域有一个实验证明了一个事情,就是,人眼在注视时并非完全静止,而是不断进行微小的运动。 正是这些不自主的眼球运动,保证了我们对静止图像的持续感知。 这样的视错觉图,基本上都是利用了我们这个会自己运动的特征,来做出动态效果的。 为了使人类能够看见,视网膜上的图像必须持续发生一定程度的运动。 反过来讲,如果某个视野保持严格的静止,那么在1~3秒内,该区域就会在视野中逐渐消失。 视觉科学里有个差不多的理论是特克斯勒消逝效应,说的是当人们长时间注视一个固定点时,周边视野中不变的刺激会逐渐淡化甚至消失。 听起来挺绕的,但如果你想试一下,刻意控制眼球静止不动的话,你可以放大这张图,然后刻意的牢牢盯住中间的十字。 应该可以感觉到十字周围的颜色在慢慢消失,然后变成一片灰白色。 这就是著名的特克斯勒消逝效应的哲学。 没有变化,则等于没有信息。 这篇文章写着写着,突然感觉回到了7、8年前还在做用户体验设计的时候,天天研究认知心理学的日子。 那时候,我们天天在研究人,研究认知心理学,研究人的行为、研究人的眼动路线、研究人的注意力、研究人的记忆,就想着,我们的产品,怎么让用户体验更丝滑一点,让他更爽一点,我们的转化率更高一点。。。 没想到这么多年以后,天天研究AI,发现到头来。 又回到了当年。 原来当年研究了那么久的知识,在如今的时代,又以另一种路径,穿越了时空,散发出了新的光彩。 AI跟人,也真的都是超级有趣的物种。 在无数路径上殊途同归,却又在各自的路线上,分道扬镳。 但我还是更喜欢人一点。 毕竟,我们不仅能看到噪点中的鹿,我们还能看到沉默中的爱,看到无常中的美。 还有,那时间。 流逝的本身。 |

声明:本网转发此文章,旨在为读者提供更多信息资讯,所涉内容不构成投资、消费建议。文章事实如有疑问,请与有关方核实,文章观点非本网观点,仅供读者参考。